功能强大的GPU

NVIDIA H200 Tensor 核心GPU 具备颠覆以往的效能和记忆体功能,可大幅强化生成式人工智慧和高效能运算工作负载。 H200 是第一款搭载HBM3e 的GPU,更大更快的记忆体可加速生成式人工智慧和大型语言模型(LLM),同时强化高效能运算工作负载的科学运算。

高效能、效率高

NVIDIA H200 采用NVIDIA Hopper 架构,是第一款能以每秒4.8 TB 的速度提供141 GB HBM3e 记忆体的GPU,容量几乎是NVIDIA H100 Tensor 核心GPU的两倍,记忆体频宽则提升1.4 倍。 H200 更大、更快的记忆体能加速生成式人工智慧和LLM,同时提升高效能运算工作负载的科学运算,而且能源效率更高、总体拥有成本更低。

|

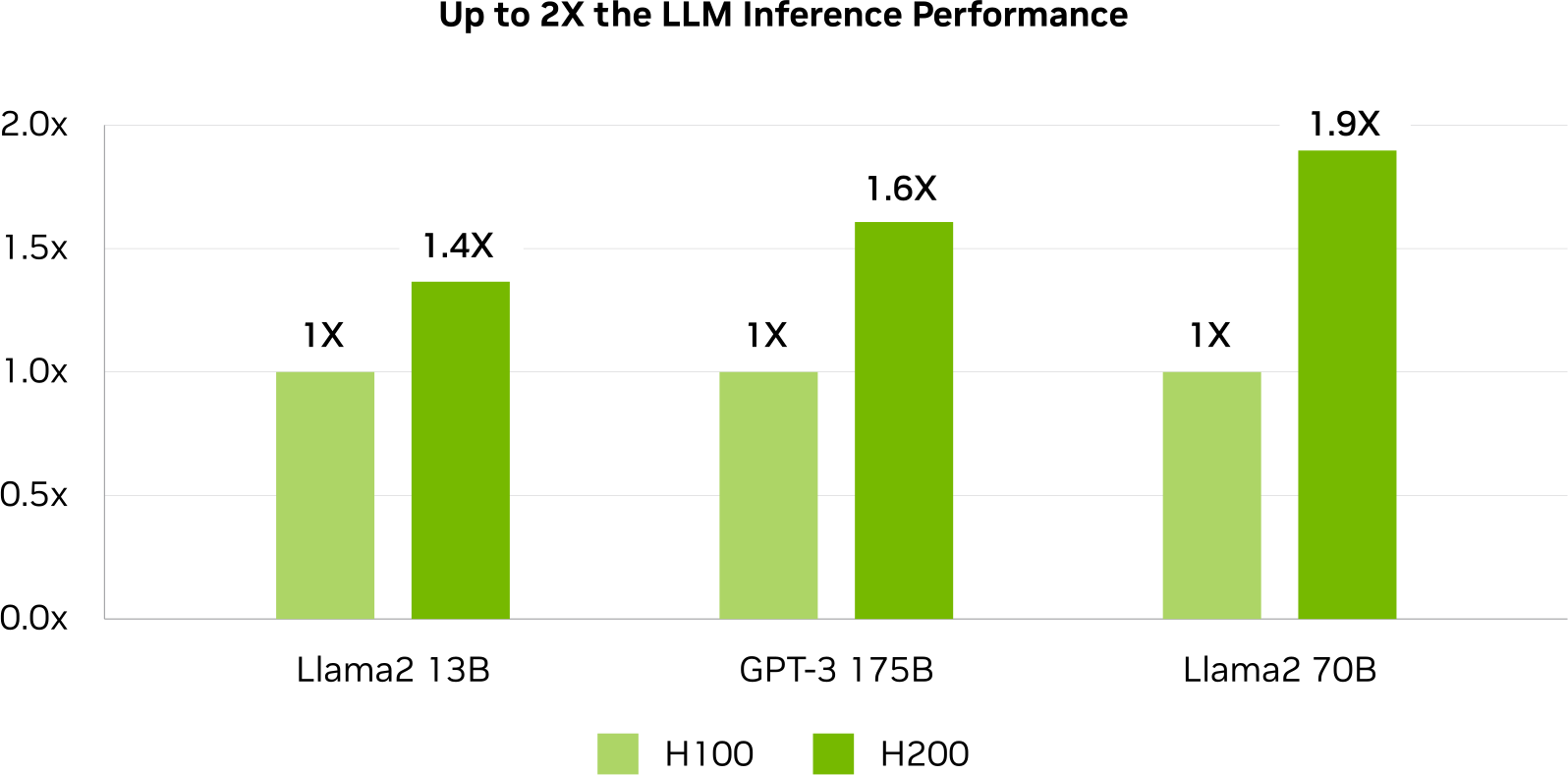

| 体验即时AI 视讯管道效能 在人工智慧不断演进的状况下,企业仰赖LLM 来因应各种推论需求。为庞大的使用者大规模部署人工智慧推论加速器时,必须运用最低的整体拥有成本达到最高的吞吐量。 与H100 GPU 相比,H200 在处理类似Llama2 的LLM 时,可将推论速度大幅提升到最高2 倍。 |

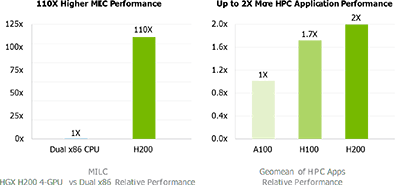

大幅强化高效能运算 就高效能运算方面的用途而言,记忆体频宽相当重要。因为这能加快资料传输速度,并减少复杂的处理瓶颈。对于需耗费大量记忆体的高效能运算应用程式,如模拟作业、科学研究和人工智慧,H200 的记忆体频宽较高,可保障资料存取和操作时的效率,因此取得结果的速度与CPU相比提升达110 倍。 |

|

|

|

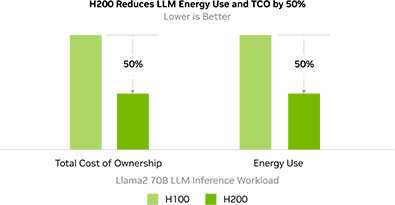

| 降低能源使用量与整体拥有成本 随着H200 的推出,能源效率和整体拥有成本将达到全新境界。这项尖端技术可提供无与伦比的效能,并且与H100 Tensor 核心GPU 使用相同的功耗设定。人工智慧工厂和超级运算系统不仅速度更快也更环保,所具备的经济优势可推动人工智慧和科学界持续进步。 |

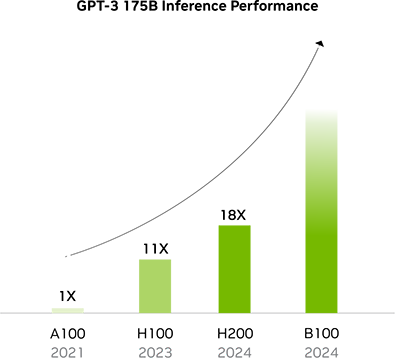

持续创新让效能持续提升 NVIDIA Hopper 架构提供超越前代产品的效能,并且不断强化H100 的软体功能,持续树立新标竿。包括近期推出了强大的开放原始码函式库,如NVIDIA TensorRT-LLM™。 H200 推出后,将会以更优异的效能延续这股趋势。投资此软体不仅能确保目前在效能上的领先地位,并透过对支援软体的持续改进,能确保未来的效能优势。 |

|

|

|

| 适用于企业:人工智慧软体可简化开发和部署的流程 NVIDIA AI Enterprise 搭配NVIDIA H200 使用,可简化人工智慧平台的建构过程,进而加速开发和部署可用于实际生产环境的生成式人工智慧、电脑视觉、语音人工智慧等技术。两者相结合,可带来企业级的安全性、管理能力、稳定度和支援服务,以便更快速地收集实用的洞察,并加速实现有形商业价值。 |

强川科技 — 专业IT综合服务提供商 【业务领域:计算机硬件、系统软件、系统集成、IT运维外包】

成都强川公司英伟达/NVIDIA产品销售团队经过多年深耕与发展,至今已成功助力超过数千家中小企业的成长。一直以来, 我们的几十位销售顾问和技术专家,坚持以倾听您的需求和愿望为工作核心,以丰富的方案经验、敏锐的行业洞察和过硬的IT技术,为您提供高匹配度的解决方案,帮您做出更明智的决定。

立即咨询

立即咨询