加速运算数量级跃进

利用NVIDIA H100 Tensor 核心GPU,提供所有工作负载前所未有的效能、可扩充性和安全性。使用NVIDIA ® NVLink ® Switch 系统,最高可连接256 个H100 来加速百万兆级工作负载,此外还有专用的Transformer Engine,可解决一兆参数语言模型。 H100 所结合的技术创新,可加速大型语言模型速度,比前一代快上30 倍,提供领先业界的对话式人工智慧。

强化大型语言模型的推理

对于高达1750 亿参数的LLM,基于PCIe 的H100 NVL 与NVLink 桥接器利用Transformer Engine、NVLink 和188GB 的HBM3 内存,提供最佳效能和易于在任何数据中心进行扩展,使LLM 成为主流。配备H100 NVL GPU 的伺服器,在功耗受限的资料中心环境中,将GPT-175B 模型效能提高多达NVIDIA DGX™ A100 系统的12 倍,同时保持低延迟。

|

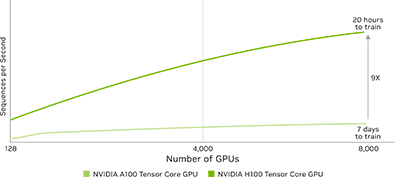

| 颠覆性人工智慧训练 H100 配备第四代Tensor 核心和具有FP8 精确度的Transformer Engine,与前一代混合专家演算法(MoE) 模型相比,训练速度高达9 倍。结合第四代NVlink (每秒提供900 GB GPU 对GPU 互连)、NVLINK Switch 系统(加速所有GPU 跨节点集体通讯能力)、第五代PCIe 和NVIDIA Magnum IO™ 软体,提供小型企业到大规模统一GPU 丛集高效率可扩充性。 部署资料中心规模H100 GPU,可提供优异效能,并且让所有研究人员均能使用新一代百万兆级高效能运算(HPC) 和一兆参数人工智慧。 |

即时深度学习推论 人工智慧使用各种不同的神经网路,解决各式各样的商业挑战。强大的人工智慧推论加速器,不只能提供最高效能,还能提供加速这些网路的各种功能。 H100 解决方案进一步扩展NVIDIA 在推论领域的市场领先地位,并创造多项进展,包含加速推理速度达高达30 倍,并实现最低延迟时间。第四代Tensor 核心加速所有精确度,包括FP64、TF32、FP32、FP16、INT8,以及目前的FP8,能够减少记忆体使用量并提升效能,且仍然能够维持大型语言模型的正确度。 |

|

|

|

| 百万兆级高效能运算 NVIDIA 资料中心平台持续提供超越摩尔定律的效能提升。 H100 全新突破性人工智慧功能,进一步放大高效能运算搭配人工智慧强大功能,加速科学家和研究人员探索时间,解决全球最重要的挑战。 H100 将双精确度Tensor 核心的每秒浮点运算次数(FLOPS) 提高为3 倍,提供高效能运算每秒60 兆次浮点运算的FP64 运算。融合人工智慧的高效能运算应用程式,能利用H100 的TF32 精确度,达到单精确度矩阵,乘法运算每秒1 petaFLOP 浮点运算输送量,而且无须变更程式码。 HH100 也配备全新DPX 指令,提供比NVIDIA A100 Tensor 核心高出7 倍的效能,而且与应用于DNA 序列校准的Smith-Waterman 等适用动态程式设计演算法的传统双插槽CPU 伺服器相比,速度快40 倍。 |

持续创新让效能持续提升 人工智慧应用程式开发时,资料分析通常耗费了大部分的时间。由于大型资料集分散在多个伺服器,仅使用CPU 设备伺服器的横向扩充解决方案,将因为缺乏可扩充运算效能而陷入困境。 使用H100 的加速伺服器,除了提供运算强大功能外,每个GPU 提供每秒3 TB 记忆体频宽,并且可扩充使用NVLink 和NVSwitch,能够支援大型资料集,高效能且大规模处理资料分析。将NVIDIA 资料中心平台与NVIDIA Quantum-2 Infiniband、Magnum IO 软体、GPU 加速的Spark 3.0 和NVIDIA RAPIDS ™搭配使用,能以无与伦比的效能和效率水准加速这些巨大的工作负载。 |

|

|

|

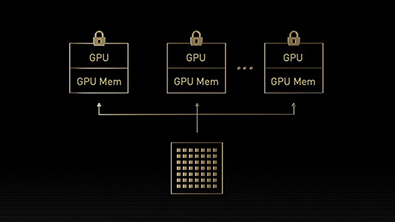

| 支持企业采用 IT 经理希望能将资料中心运算资源使用率提到最高(包含峰值和平均值)。他们通常会针对使用的工作负载中适当大小的资源,采用运算动态重新设定。 H100 中的第二代多执行个体GPU (MIG),能够安全分割每个GPU 为多达七个独立执行个体,最大化各个GPU 的使用率。 H100 提供机密运算支援,能够安全进行端对端、多租用户使用,是云端服务供应商(CSP) 环境的理想选择。 使用多执行个体GPU 的H100 能够让基础架构管理员标准化GPU 加速基础架构,同时具备更大弹性布建更细致的GPU 资源,安全地提供开发人员合适的加速运算功能,并最佳化所有GPU 资源使用。 |

内建机密运算 现今的机密运算解决方案以CPU 为基础,对人工智慧和高效能运算等运算密集的工作负载来说限制过大。 NVIDIA 机密运算是NVIDIA Hopper™ 架构的内建安全功能,让H100 成为全球第一个具有机密运算功能的加速器。使用者能够利用无可匹敌的H100 GPU 加速能力,同时保护使用者资料和应用程式的机密与完整性。 NVIDIA H100 GPU 建立了以硬碟为基础的可信任执行环境(TEE),保护并隔离在单一H100 GPU、节点中多个H100 GPU 或个别多执行个体GPU 的执行个体上,执行的所有工作负载。 GPU 加速的应用程式无须修改就能在可信任执行环境中执行,且不必分割。使用者可以结合使用在人工智慧与高效能运算的NVIDIA 软体强大功能,以及NVIDIA 机密运算提供的硬体信任根安全性。 |

|

|

强川科技 — 专业IT综合服务提供商 【业务领域:计算机硬件、系统软件、系统集成、IT运维外包】

成都强川公司英伟达/NVIDIA产品销售团队经过多年深耕与发展,至今已成功助力超过数千家中小企业的成长。一直以来, 我们的几十位销售顾问和技术专家,坚持以倾听您的需求和愿望为工作核心,以丰富的方案经验、敏锐的行业洞察和过硬的IT技术,为您提供高匹配度的解决方案,帮您做出更明智的决定。

立即咨询

立即咨询